実のところ、複数の在庫場所に対応した在庫管理システムの構築は難度が上がってしまうのですが、なんとかコアの部分だけでも本記事でご説明させていただきます。

倉庫など場所別に在庫数を把握する

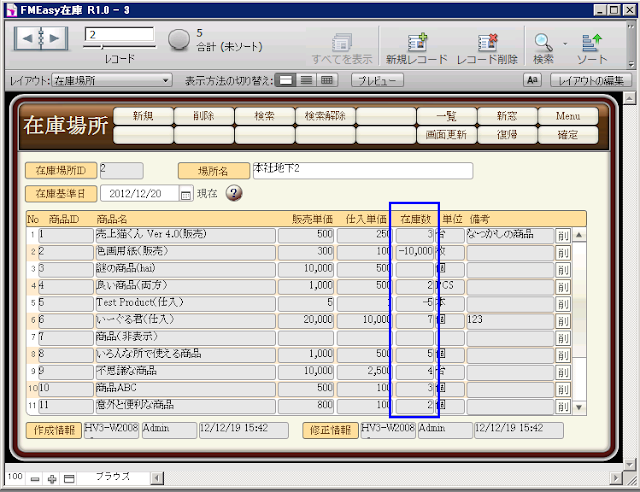

ここでは、『FMEasy在庫 R1.0』で複数の在庫場所を管理できるように、仕様変更してみることにします。

これまでに弊社の在庫管理講習を受講された方、または『FMEasy在庫R1.0(開発版)』ユーザ、倉庫別在庫管理の考え方を学びたい方の参考になれば幸いです。

- テーブル設計

- 在庫場所テーブル (新設、倉庫/保管場所等管理用マスタ)

- ID(主キー)

- 場所名(テキスト)

- 場所別在庫TB(新設)

- ID(主キー)

- 場所ID(外部キー)

- 商品ID(外部キー)

- 導入時在庫数(数値、導入時に元々あった商品在庫数を在庫場所別に記録)

- 繰越在庫数(数値、繰越処理実行時に特定時点の商品在庫数を在庫場所別に記録)

- c場所別在庫数(場所別在庫算出用計算フィールド)

- g在庫基準日1/g在庫基準日2(入出庫の期間特定用グローバルフィールド)

- 入庫テーブル/出庫テーブル(変更)

- 入庫場所ID/出庫場所ID(新設、入出庫場所を登録)

- 入出明細TB(変更)

- 在庫場所ID(新設、入庫テーブル/出庫テーブルの入庫場所ID/出庫場所IDをコピーする)

- リレーションシップ設計

- レイアウト(LAY)/スクリプト設計

- 在庫場所LAY(新設、場所別の在庫数をポータルに表示)

- 入庫LAY/出庫LAY(変更)

- 入庫場所ID/出庫場所IDを配置する

- OnRecordCommitで入庫場所ID/出庫場所IDを入出明細テーブルの在庫場所IDフィールドにコピー

- OnRecordCommit時、必要に応じて場所別在庫レコードを作成(4-a参照)

- 考慮すべき事項

- 場所別在庫レコードを作成するタイミング 複数倉庫がある等、場所別に在庫を管理しようとすると、FileMakerの場合、どうしても場所別に商品を登録しておく専用テーブル(場所在庫テーブル)が必要になる。そこで、場所別在庫レコードを登録するタイミングが問題となる。余分なレコードをテーブルに極力保持しないためには、入出庫レコード登録時(OnRecordCommit)に、未登録商品の場所別在庫レコードを登録するように制御する。

- 倉庫間移動に対応

- 出庫時、倉庫1の出庫伝票を、入庫時、倉庫2の入庫伝票を作成

- 倉庫2の入庫伝票作成漏れを防ぐ

- 倉庫2の入庫伝票作成後の関連伝票更新をどう考えるか?

- 出入庫同時作成機能(商品の近接場所間移動時)

- その他

リレーションシップ

まず、テーブルでキモとなるのが場所別在庫テーブルですね。このテーブルにより、場所別に商品在庫数の算出が可能となります。

ここで特に重要なフィールドは、在庫場所ID、商品ID、c場所別在庫数(計算フィールド)です。なお、下図で場所名と商品名は商品テーブルと在庫場所テーブルを参照しています。

【場所別在庫テーブルを表形式レイアウトに表示】

在庫算出部分のリレーション。

↓

入出明細テーブルには商品ID/在庫場所ID(出庫元/入庫先の在庫場所ID)と入出庫数が登録されているわけだから、入出明細テーブルと場所別商品在庫テーブル上記のようにリレートして、以下のように計算式フィールをを作ればよいでしょう。

元々ある在庫+特定期間のSum(入庫数)-特定期間のSum(出庫数)

注:

「元々ある在庫」は繰越処理が未実行であれば[導入時在庫数]、実行済であれば[繰越在庫数]となり、「特定期間」はユーザが指定する[g在庫基準日1]と、[g在庫基準日1]のOnObjectValidate/Saveで起動するスクリプトにより制御された[g在庫基準日2]の値により決まります。

[g在庫基準日2]の設定値については、「簡単? FileMakerで在庫管理(2)」の図が参考になると思います。

他にもリレーションシップの追加はあるのですが、難しくないので省略します。

レイアウトとスクリプト

入庫/出庫レイアウトには、それぞれのテーブルで新設した[入庫場所ID]と[出庫場所ID](入出庫した場所を示すID)を登録し、OnRecordCommit時に入出庫明細テーブルの[在庫場所ID]にコピーします。

なお、Commit時に、入出明細テーブルに入力されている[商品ID]で場所別在庫テーブルに未登録の商品は登録するという、第2のキモともいうべきスクリプトについては、できれば機会を改めて書きたいと思います。

【出庫レイアウト】

最後に在庫場所別に商品在庫数を表示するレイアウト。ユーザが[在庫基準日]に日付入力することにより、その日付時点の各商品の在庫数が表示されます。

【在庫場所レイアウト】

|

ポータル部分に在庫数(=場所別在庫::c場所別在庫数)と商品テーブルの情報が表示されます。 |

上述の場所別在庫のレコード作成処理や、繰越処理は別途作成しなければなりませんが、意外と実装に時間はかかりませんでした。

(土屋)

既存のテーブル列を使ってリレーションシップを設定する

既存のテーブル列を使ってリレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対1 の非依存型(non identifying)リレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対1 の非依存型(non identifying)リレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対多の非依存型(non identifying)リレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対多の非依存型(non identifying)リレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対1 の依存型(identifying)リレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対1 の依存型(identifying)リレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対多の依存型(identifying)リレーションシップを設定する

外部キー専用の列を子テーブルに新規追加し、1対多の依存型(identifying)リレーションシップを設定する

多対多のリレーションシップを設定する

多対多のリレーションシップを設定する